离GPT-5最近的一次!中国1万亿参数开源巨兽突然爆火

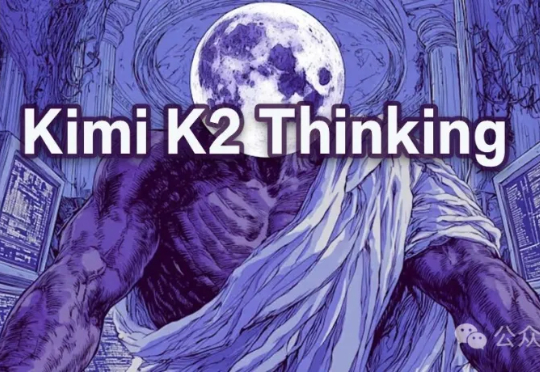

离GPT-5最近的一次!中国1万亿参数开源巨兽突然爆火昨天,月之暗面发布全新模型Kimi K2 Thinking,一上线就挤爆了服务器。思考,是它的核心卖点,自称是开源的「思考Agent模型」。在Tau2 Bench Telecom基准测试中,K2 Thinking位列第一。

昨天,月之暗面发布全新模型Kimi K2 Thinking,一上线就挤爆了服务器。思考,是它的核心卖点,自称是开源的「思考Agent模型」。在Tau2 Bench Telecom基准测试中,K2 Thinking位列第一。

Kimi K2 Thinking,现已发布并开源!

四个月前 Kimi 发布了 K2 模型,凭借优秀的质量以及先进的架构优化,一举打破了持续了几个月关于月之暗面的质疑。 我当时也写了两篇测评《Kimi K2 详测|超强代码和Agent 能力!内附Cla

微调超大参数模型,现在的“打开方式”已经大变样了: 仅需2-4 张消费级显卡(4090),就能在本地对DeepSeek 671B乃至Kimi K2 1TB这样的超大模型进行微调了。

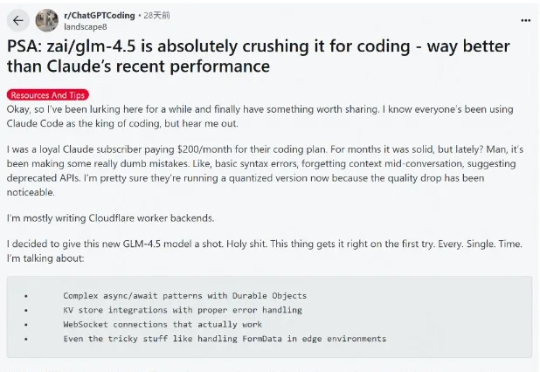

刚刚,这样一个消息在 Reddit 上引发热议:硅谷似乎正在从昂贵的闭源模型转向更便宜的开放源替代方案。

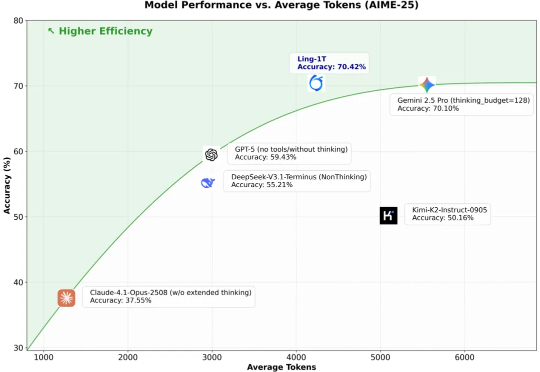

10 月 9 日凌晨,百灵大模型再度出手,正式发布并开源通用语言大模型 Ling-1T ——蚂蚁迄今为止开源的参数规模最大的语言模型。至此,继月之暗面Kimi K2、阿里 Qwen3-Max 之后,又一位重量级选手迈入万亿参数LLM 「开源俱乐部」。

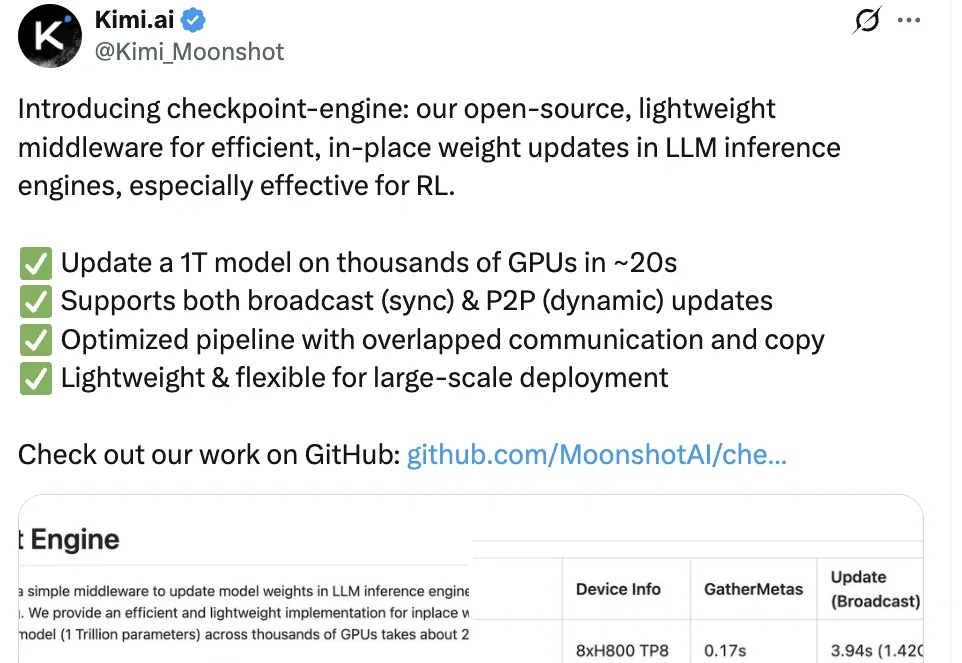

Kimi开源又双叒放大招了!

智东西9月5日消息,刚刚,大模型独角兽月之暗面发布新模型Kimi K2-0905,目前,Kimi应用和网页版中的K2模型已全量升级到Kimi K2-0905。该模型的核心升级点为Agentic Coding能力增强、支持256K上下文、API支持高达60-100Token/s的输出速度、支持Claude Code。

随着DeepSeek R1、Kimi K2和DeepSeek V3.1混合专家(MoE)模型的相继发布,它们已成为智能前沿领域大语言模型(LLM)的领先架构。由于其庞大的规模(1万亿参数及以上)和稀疏计算模式(每个token仅激活部分参数而非整个模型),MoE式LLM对推理工作负载提出了重大挑战,显著改变了底层的推理经济学。

这段时间 AI 编程的热度完全没退,一个原因是国内接连推出开源了不少针对编程优化的大模型,主打长上下文、Agent 智能体、工具调用,几乎成了标配,成了 Claude Code 的国产替代,比如 GLM-4.5、DeepSeek V3.1、Kimi K2。